本文上接:浅谈医学大数据(中)3. 大数据特性对统计应用上的际遇和冲击大数据的独特性对传统的统计方法发出了挑战,刺激着新的,适用于大数据分析的统计方法的发展。本文提到的一些际遇和问题,一部分是作者自己的观点,一部分摘自其他文章( (Fan, Han, & Liu, 2014) (Wang & Wang, 2014)。相较于统计文章的专业写作手法,作者试图用更浅显易懂的说法来介绍这些问题,让一般的读者对此也能有一定的了解并对此产生兴趣。传统数据一般来说是样本量远远大于感兴趣的因素,比如一数据有200条记录关于个人是否有心血管病,可能相关因素为性别,年龄,血压。这儿只有4个因素,但样本量为200(200>>4)。而大数据则拥有海量的样本及相当多的因素。还是用心血管的例子,现在比如我们有了几万条记录的样本量,但同时也拥有了上百个的因素,各种以前没法收集的因素都收集了,像运动与否,运动量如何,运动类型,饮食习惯,饮食内容,喝酒与否,喝什么酒,喝酒习惯次数等等。这使统计中对数据的研究应用得到了新的际遇同时也面临了新的挑战。3.1. 数据异质性(heterogeneity)数据异质性,可以简单理解成一个大样本数据里有很多小样本,每个小样本有着不同的数据特征,比如小样本的平均值有高有低,离散程度有密有疏,就好象海洋中有着不同温度,不同密度的各种洋流一样。我们不能简单的只在大样本的层面进行统计分析,这样得出的结果如果被用于对小样本或样本中的个体的估计或预测时就会出现偏差,因为每个小样本可能有着一些它自己独特的特征。在数据样本小的时候,里面的小样本相应的就更小。 这种情况下小样本里的数据记录可能只有一,两个,它们只能被当作异常值处理,无法分析。而在大数据里,这种具有独特特征的数据记录收集出现多了,就拥有了被统计分析的条件,从而使我们更好地探究特定因素的关联性,理解这些数据异质性。比如有些只在特定人群里发生的极其罕见的疾病,大数据使我们得以研究发病原因,发病风险因素;理解为什么有些治疗方法对某些人群有利,而同样的方法对另一人群却有害,等等。

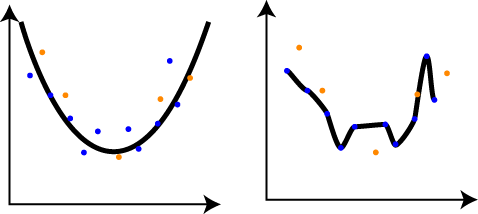

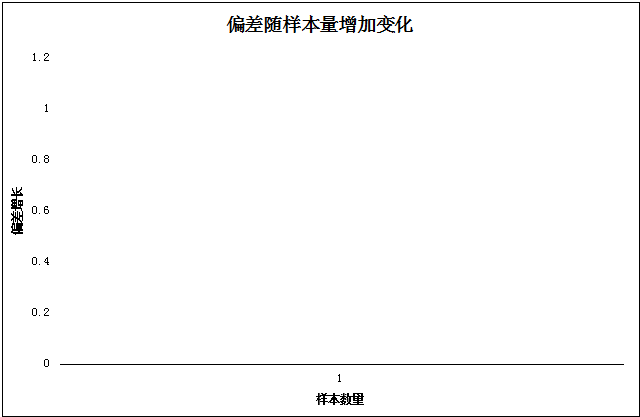

同样,由于海量样本和巨多的因素存在于大数据里,信息的复杂度也会增加不少,受复杂度的影响,可能导致统计上的过度拟合(overfitting)。过度拟合就是指我们建立了一个复杂的统计模型,它能很好的描述现有数据的情况,但当我们想把这模型应用到预测新数据时,它的表现却相当差。比如图九所示: 图九: 来源:https://shapeofdata.wordpress.com/2013/03/26/general-regression-and-over-fitting/ 图九左边上的曲线是我们针对蓝点(当作现有数据)做出的模型,基本上能很好的描述蓝点的分布及曲线和蓝点的吻合度较高。用这曲线去描述黄点(当作新数据),吻合度也还不错。图九右边的曲线则完全通过了每一蓝点,吻合度极高,完全描述了蓝点的复杂特性。然而,它在描述黄点时,吻合度就差多了,偏差就比左边的曲线大不少。简单来说,数据越复杂,需要考虑的因素越多,建立普遍有效的统计模型的难度就越大。3.2. 偏差识别(Bias accumulation)分析数据时,我们需要估计或测试很多参数用以建立可靠的统计数据模型。期间不可避免会产生偏差,这些估计中产生的偏差积累,很大程度上受着数据量大小及参数多寡的影响。 在一般小数据时,这问题可以并不显著。但在大数据的情况下,这问题就变的相当值得注意。 我们用一简化的例子来说明这个问题。假设我们有两组数据A和B,A组数据收集估算时没有偏差,所有样本数值都为1000。B组数据,实际所有样本数值也是1000,但存在偏差,而且偏差随收集样本量的增加呈指数式成长(为了说明情况,偏差指数式成长是一个很极端的例子)。每增加一个记录,偏差增长公式为:

来源:https://shapeofdata.wordpress.com/2013/03/26/general-regression-and-over-fitting/ 图九左边上的曲线是我们针对蓝点(当作现有数据)做出的模型,基本上能很好的描述蓝点的分布及曲线和蓝点的吻合度较高。用这曲线去描述黄点(当作新数据),吻合度也还不错。图九右边的曲线则完全通过了每一蓝点,吻合度极高,完全描述了蓝点的复杂特性。然而,它在描述黄点时,吻合度就差多了,偏差就比左边的曲线大不少。简单来说,数据越复杂,需要考虑的因素越多,建立普遍有效的统计模型的难度就越大。3.2. 偏差识别(Bias accumulation)分析数据时,我们需要估计或测试很多参数用以建立可靠的统计数据模型。期间不可避免会产生偏差,这些估计中产生的偏差积累,很大程度上受着数据量大小及参数多寡的影响。 在一般小数据时,这问题可以并不显著。但在大数据的情况下,这问题就变的相当值得注意。 我们用一简化的例子来说明这个问题。假设我们有两组数据A和B,A组数据收集估算时没有偏差,所有样本数值都为1000。B组数据,实际所有样本数值也是1000,但存在偏差,而且偏差随收集样本量的增加呈指数式成长(为了说明情况,偏差指数式成长是一个很极端的例子)。每增加一个记录,偏差增长公式为:

Y=1.001x这样B组第一个记录包含偏差为1.001=1.0011. B组第一个值为1000×1.001=1001. B组第二个记录包含偏差为1.002001=1.0012. B组第一个值为1000×1.002001=1002.001. B组第十个值为1000×1.01004512=1010.045.这样如果是小数据n=10, A组数据其实和B组数据比起来相差是不大的。B组内的每一个数字增加的偏差不足以引起注意,如果2%以内的偏差都可以接受的话。表格一:

| 记录号 | A组 | B组 | 偏差比例 |

| 1 | 1000 | 1001 | 0.10% |

| 2 | 1000 | 1002.001 | 0.20% |

| 3 | 1000 | 1003.003 | 0.30% |

| 4 | 1000 | 1004.006 | 0.40% |

| 5 | 1000 | 1005.01 | 0.50% |

| 6 | 1000 | 1006.015 | 0.60% |

| 7 | 1000 | 1007.021 | 0.70% |

| 8 | 1000 | 1008.028 | 0.80% |

| 9 | 1000 | 1009.036 | 0.90% |

| 10 | 1000 | 1010.045 | 1.00% |

然而当我们收集了1万个数据记录后,情况就发生了很大的变化。我们来看最后10个数据相差情况已经相当相当大了。表格二:

| 记录号 | A组 | B组 | 偏差比例 |

| 9991 | 1000 | 21742134 | 2174113.43% |

| 9992 | 1000 | 21763876 | 2176287.64% |

| 9993 | 1000 | 21785640 | 2178464.03% |

| 9994 | 1000 | 21807426 | 2180642.59% |

| 9995 | 1000 | 21829233 | 2182823.33% |

| 9996 | 1000 | 21851063 | 2185006.26% |

| 9997 | 1000 | 21872914 | 2187191.36% |

| 9998 | 1000 | 21894787 | 2189378.66% |

| 9999 | 1000 | 21916681 | 2191568.13% |

| 10000 | 1000 | 21938598 | 2193759.80% |

A组数据和B组数据,在拥有海量的数据样本的情况下,相差已是十万八千里了。图十显示了偏差随样本量增加的变化情况。在样本数量为4236左右,偏差的增加还不明显。一过4236,偏差则出现了惊人的增长。图十: 所以依此为判断的话,我们可以说在数据样本量4000左右,A组和B组比较,差别可能不大。但数据样本量大于4000以后,A组和B组比较,可能就会相当不一样了。这个例子充分说明了大数据相比较小数据而言对数据偏差更容易进行识别,从而发现数据收集过程中的问题并加以改善。3.3. 虚假相关(spurious correlation)虚假相关,我们用一个例子来加以解释说明。这儿还是以前面提到过的心血管数据为例。现在只收集了200个记录,但每条记录都有100个各方各面因素的信息。这样,我们想看是否这100个因素和“是否有心血管病”相关。如此,我们进行两两检验测试: 是否有心血管病和因素一进行检验,是否有心血管病和因素二进行检验……是否有心血管病和因素一百进行检验。每一个检验测试结果只会出现两种情况: 统计学上有意义和统计学上无意义。统计学上有意义,简单来说就是认为心血管病和该因素有关。统计学上无意义就是认为心血管病和该因素无关。 在此过程中,你可能发现,大约会有5次在统计学上被认为与心血管病相关的因素,实际上从常识和现实来判断是没有任何关联的,也就是说统计学上有意义是错误的。这就是虚假相关。

所以依此为判断的话,我们可以说在数据样本量4000左右,A组和B组比较,差别可能不大。但数据样本量大于4000以后,A组和B组比较,可能就会相当不一样了。这个例子充分说明了大数据相比较小数据而言对数据偏差更容易进行识别,从而发现数据收集过程中的问题并加以改善。3.3. 虚假相关(spurious correlation)虚假相关,我们用一个例子来加以解释说明。这儿还是以前面提到过的心血管数据为例。现在只收集了200个记录,但每条记录都有100个各方各面因素的信息。这样,我们想看是否这100个因素和“是否有心血管病”相关。如此,我们进行两两检验测试: 是否有心血管病和因素一进行检验,是否有心血管病和因素二进行检验……是否有心血管病和因素一百进行检验。每一个检验测试结果只会出现两种情况: 统计学上有意义和统计学上无意义。统计学上有意义,简单来说就是认为心血管病和该因素有关。统计学上无意义就是认为心血管病和该因素无关。 在此过程中,你可能发现,大约会有5次在统计学上被认为与心血管病相关的因素,实际上从常识和现实来判断是没有任何关联的,也就是说统计学上有意义是错误的。这就是虚假相关。

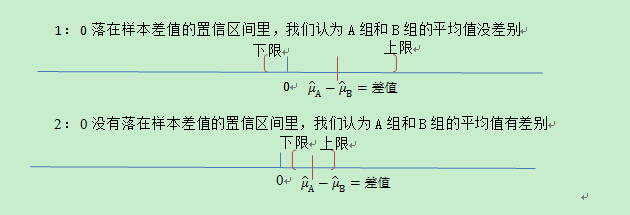

为了让我们能知其然也知其所以然,这儿要解释一下“统计学上有意义”究竟是怎么界定的 。一般做检验测试时,我们会界定一个值,叫做第一类统计错误率。这个错误率通常被设定为5%,也就是说每100次检验测试,我们允许有5次在统计学上实际无意义的被错误判断为统计学上有意义(如果不允许统计错误率的存在,那就是100%的正确率,也就是说没有不确定性的存在。如果有这样的数据,就不需要做任何统计上的假设检验了)。也就是说,如果实际不存在相关性,我们允许100次假设检验中出现5次错误相关。这就是以上例子中出现虚假相关的原因。 在面对庞大的海量数据和超多维度的因素时,当同时对一个数据进行许多检验测试时,不可避免会出现虚假相关。如何处理这个问题,统计学上还在做着进一步的研究。3.4. 无意义显著性(meaningless significance)还有一种情况我们称为无意义的显著性 (Lin, Lucas, & Shmueli, 2013)。当我们做两组数据的分析比较时,如果A组,B组各只有1000个数据记录,我们测试两组数据的平均值是否一样,结果告诉我们统计学上无意义。也就是说,这两组数据的平均值无统计学上的差异。但当数据记录达到上万上百万时,测试的结果告诉我们统计学上是有意义的了。这又是怎么回事?我们回到源头上去看,为什么要做两组数据的统计分析比较?不可以就算出两组的平均值,比一比他们是否相同吗?当然不可以,因为我们真正希望分析比较的结果是能够反映100%总体数量数据的客观现象。单纯孤立的比较两组各1000个记录的平均值,就是比大小,比出来的结论不能推广到100%总体数量数据的客观现象上。但这两组数据等同于100%总体数量数据吗? 当然不是,就算是海量的大数据也并不能100%等同于总体数量数据。这样我们分析总结出的这两组数据的一些统计指标就会和总体数量数据的统计指标有一定的偏差。这个偏差一般有一个下限和上限,我们称为置信区间。真实的总体数量数据的统计指标就落在样本数据统计指标的左边或右边的一定范围内(置信区间)。好了,我们实际要看的是A组总体数量数据和B组总体数量数据在平均值上是否一样,换种说法就是A组总体数量数据平均值减B组总体数量数据平均值是否等于零: 。现在我们只有A组样本数量数据平均值和B组样本数量数据平均值,表达符号就是和。要看的就是A组样本数量数据平均值减B组样本数量数据平均值的差值是否等于0: 但我们已经知道由于样本均分差的存在,样本平均值相减的差值不一定是零,而且这个差值有一定的置信区间。 那么我们实际上更精确的说是看0是否落在样本差值的置信区间内(置信区间的上限和下限和上面提到的第一统计错误率是相一致的,有一个5%的概念在里面,这儿就不详细介绍了。反正是否落在置信区间里否也可以用来判断统计学上是有意义还是没有意义)。落在里面我们就说是统计学上是没有意义的也就是两组数据的平均值是一样。不落在里面我们就说是统计学上是有意义的也就是两组数据的平均值不一样。如图十一所示:图十一: 那为什么在样本数据量为1000和 上万上百万的情况下结果会不一样。这儿我们进一步要讲的就是样本数量和置信区间之间的关系了。随着样本数量的增加,样本差值会和真实的总体数据差值接近(不一定就是0哦),同时不确定性会减小,置信区间会缩短,其实就是估计的差值越来越精准了。这种情况下,就算样本差值是非常接近0的一个数(就是说我们都觉得两组数据的平均值是一样的了),但是由于置信区间的缩小,0仍旧会落在置信区间的外面(如图十一,下部分2所示)。这样一来,结果就会是统计学上是有意义的:两组数据的平均值是不一样的。现有的统计方法运用在大数据时会带来这样的一种错误信息。这是因为现有的传统统计方法是针对小数据的,在被提出的时候,还没有面对过或想到数据量可以如此庞大。如何解决如何改进由于这样的数据特性带来的问题,我们还在研究的路上。3.5. 羊群效应(herding effect)大数据时代,我们的社会已经在越来越多的把个人的观点数字化,汇总化,并依赖于此做出决策(比如根据收集到的评分来进行产品或服务的推荐)。这一现象在医疗界也渐渐的变的普遍起来。好多辅助医疗应用软件在移动平台上都会有使用者的评分,人们会根据评分来选择是否使用一下。某些医疗网络平台推出的服务,比如网络问诊,使用者也可以对提供服务的医疗人员进行满意度的评分,进而影响他人决定是否选择此医疗人员来进行问诊咨询。

那为什么在样本数据量为1000和 上万上百万的情况下结果会不一样。这儿我们进一步要讲的就是样本数量和置信区间之间的关系了。随着样本数量的增加,样本差值会和真实的总体数据差值接近(不一定就是0哦),同时不确定性会减小,置信区间会缩短,其实就是估计的差值越来越精准了。这种情况下,就算样本差值是非常接近0的一个数(就是说我们都觉得两组数据的平均值是一样的了),但是由于置信区间的缩小,0仍旧会落在置信区间的外面(如图十一,下部分2所示)。这样一来,结果就会是统计学上是有意义的:两组数据的平均值是不一样的。现有的统计方法运用在大数据时会带来这样的一种错误信息。这是因为现有的传统统计方法是针对小数据的,在被提出的时候,还没有面对过或想到数据量可以如此庞大。如何解决如何改进由于这样的数据特性带来的问题,我们还在研究的路上。3.5. 羊群效应(herding effect)大数据时代,我们的社会已经在越来越多的把个人的观点数字化,汇总化,并依赖于此做出决策(比如根据收集到的评分来进行产品或服务的推荐)。这一现象在医疗界也渐渐的变的普遍起来。好多辅助医疗应用软件在移动平台上都会有使用者的评分,人们会根据评分来选择是否使用一下。某些医疗网络平台推出的服务,比如网络问诊,使用者也可以对提供服务的医疗人员进行满意度的评分,进而影响他人决定是否选择此医疗人员来进行问诊咨询。

利用这种“众人的智慧”的一个关键要求是个人意见的独立性。然而,在现实的世界中,汇总收集的集体意见却很少是由互不相干的独立的个体意见所组成的。最近的实验研究证明先前已经存在的收集到的意见会歪曲随后个人的决策还有对质量及价值的认知。凸显出了一个根本的差异既: 我们从集体意见感知到的价值和产品本身固有的价值之间的差异。产生这种差异的原因在于“羊群效应” 。羊群效应简单的描述就是个体的从众跟风心理和行为。羊群是一种很散乱的组织,平时在一起也是盲目地左冲右撞,但一旦有一只头羊动起来,其他的羊也会不假思索地一哄而上,全然不顾前 面可能有狼或者不远处有更好的草。因此,“羊群效应”就是比喻一种从众效应,很容易导致盲从,而盲从往往会陷入认知偏差,决策偏差。

IBM Watson 研究中心 (Wang & Wang, 2014)使用大规模纵向的客户评分数据集(亚马逊的)并建立统计模型演示了评分和意见的产生不是独立,均匀的过程,而是创建了一个环境进而影响以后评分或意见的产生。体现在这种社会化的客户评分系统中的“羊群效应”具体表现为:高评分倾向于产生新的高评分同时抑制低评分的产生。接下来的问题就是:什么是真实的符合产品真正质量的评分如果我们能把“羊群效应”给剔除出去的话? 应用IBM Watson 研究中心建立的统计模型能够部分回答这个问题。他们对亚马逊的四类产品数据(书籍,电子产品,电影电视,和音乐)进行了内在评分(剔出“羊群效应”)和外在(没有剔出“羊群效应”)测试。所有四个类别,50%以上的产品评分的差异大于0.5。这个差异,说明我们从集体评分中得来的感知和产品的真实价值之间存在着显著的差异。再深一步,鉴于产品现在的评分,如果我们施加一定的人为操纵,“羊群效应”会如何影响今后的评分?这样的预测分析对于很多领域都是相当有价值的,包括市场盈利估计,预算广告和欺诈操纵检测等。例如,在决定是否对以产品进行促销活动之前,市场分析师可能希望估计由于推广而出现的短期高评分对产品的长期影响。研究中心通过对两类产品(电影电视,和音乐)插入50个人为5星级的评分,预测到虽然这两种产品在受欢迎程度上遇到类似的短期高评分,从长远来看,推广对于电影及电视类产品有着更持久的影响(高评分消减的更慢)。这对于市场分析的决策提供了很有价值的情报。

此类大数据中的“羊群效应”可以通过适当的统计方法加以消除,利用,以产生更有价值的信息用于决策分析中。

以上的各个例子充分说明了在大数据时代,虽然数据库等操作建立需要专业计算机人才的贡献,统计专业人员的参与也是必不可少的。数据的管理分析并不仅仅是提取,检索,简单汇总,总结。数据本身的复杂性,使得分析的过程中充满了种种陷阱,误区。没有一定统计方面的理论知识结构,就会出现分析上的偏差,或者低效率的数据利用。在计算机算法的基础上去学习认识数据统计的性质,把算法和统计分析结合起来是未来大数据分析的一个主要方向。4. 结论和展望本文浮光掠影地讲述了什么是大数据,有选择性地描述了大数据的一些特性,医疗大数据及其在北美医疗系统中的现况,揭示了大数据分析将会对医疗卫生保健领域带来巨大的影响和冲击。 大数据通过对临床及其他数据存储库进行数据管理和分析获得前所未有的洞察力并依此做出更明智的决策。在不久的将来,大数据分析的应用将会快速,广泛的涌现在整个医疗保健机构和医疗保健行业。本文描述的数据管理框架,数据统计分析揭示了大数据的有效应用是一个系统性的工程,需要一系列专业技能来保证大数据分析的成功,包括:处理,整合,分析复杂的数据并能帮助客户充分了解数据分析的结果。要做到这些 需要多方面的专业技能及特质,包括:

• 计算机科学/数据开发的专业技能:扎实的计算机科学基础及运用能力,明了大数据的基础框架设施。

• 分析和建模能力:在了解数据的基础上迅速分析并建立有效的统计模型。这不仅需要扎实的统计学,还需要有敏锐的思考和洞察力 。

• 好奇心和创意的思考能力:这需要对数据有着一种渴望激情,善于全面敏锐的思考并挖掘问题。一些机构寻找人才就是看谁能在讨论数据时能够灵光一现。

• 突出的交流能力:整合数据和结果的分析报告,能清晰明了的用非专业语言帮助客户或公众正确理解数据分析结果并做出决定。

当然,我们很难找到一个人才具有以上所有技能,但通过团队分工合作建立起高效的大数据小组是目前可行的方向。从而, 在这个大数据分析变得更加主流的时代,把握时机,脱颖而出或百尺竿头,更进一步。本文由珍立拍授权动脉网转载。文章为作者独立观点,不代表动脉网立场。